近日,苹果机器学习研究中心发表的一篇研究论文引发 AI 领域震动。论文直指当前主流 AI 推理大模型(如 DeepSeek、o3-mini、Claude 3.7 等)本质上仅是 “模式匹配机器”,所谓的 “思考” 不过是训练数据驱动的假象。

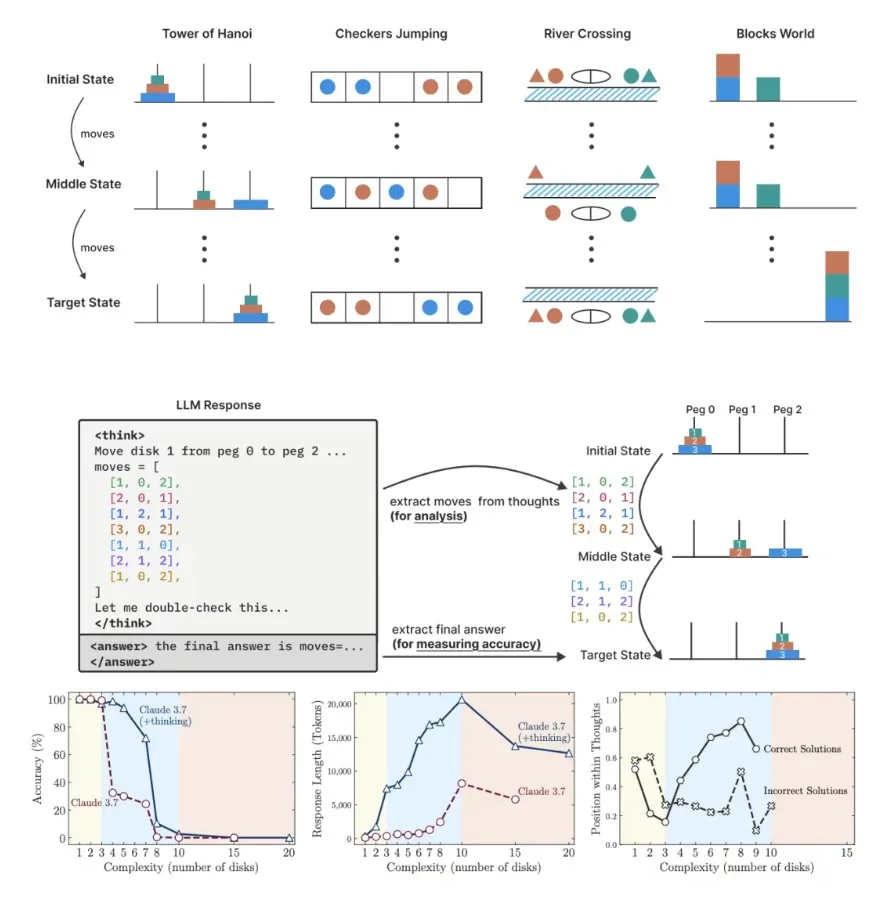

为验证模型的真实推理能力,苹果团队设计了四类可控难度的逻辑谜题 ——跳棋交换、过河问题、汉诺塔、积木世界,对多个主流 AI 模型展开测试,发现三大关键问题:

假性思考现象:模型表现高度依赖训练数据中的模式识别,而非逻辑推理。例如在汉诺塔问题中,模型早期步骤正确,但随着层数增加逐渐出错,且错误出现的时机与训练数据中同类问题的出现频率高度相关,暗示其依赖记忆而非泛化能力。

推理努力反向缩放:面对复杂度递增的问题,模型初期会延长 “思考” 时间(消耗更多 token),但接近能力阈值时,思考深度反而骤降 —— 即便仍有充足计算资源,模型也会陷入 “摆烂” 状态,暴露内在推理能力上限。

性能崩溃临界点:当问题复杂度超过某一阈值,所有模型准确率会暴跌至零,且增加计算资源也无法挽救,凸显现有模型在长程依赖和复杂规划中的结构性缺陷。

苹果团队指出,这项研究不仅挑战了基于传统数学基准的大模型评估范式,更呼吁学界采用更精细的实验设计,重新审视语言推理模型的能力边界。

消息一出,这一观点不仅迅速在 AI 领域引发了激烈争议,网友也纷纷炸锅,引发广泛讨论。

质疑派直指苹果 “酸葡萄心理”,认为苹果自身 AI 进展滞后是争议的根源。

据悉,苹果 AI 团队因高层分歧、人才流失和组织重组,导致研发效率低下 ——Siri 升级多次延期,Apple Intelligence 功能故障频发,其 AI 服务更在中国大陆已跳票一年,新闻摘要功能还曾因生成虚假信息被禁用。

有网友吐槽:“苹果手握最多资金,两年没拿出像样成果,现在落后了就否定别人,这是我搞不好就说行业有问题的心态。”

支持派,则强调研究的积极意义。这部分声音认为,苹果并非全盘否定 AI,而是呼吁改进评估标准、设计更科学的推理机制。其研究揭示的 “模式匹配本质” 和 “性能崩溃点”,正是当前行业亟待突破的瓶颈 —— 如何让模型实现真正的逻辑推理,而非依赖训练数据的 “记忆回放”。

有业内人士则指出:苹果的‘炮轰’像一面镜子,既照见自身焦虑,也反射出行业对 AI 思考本质的认知盲区。

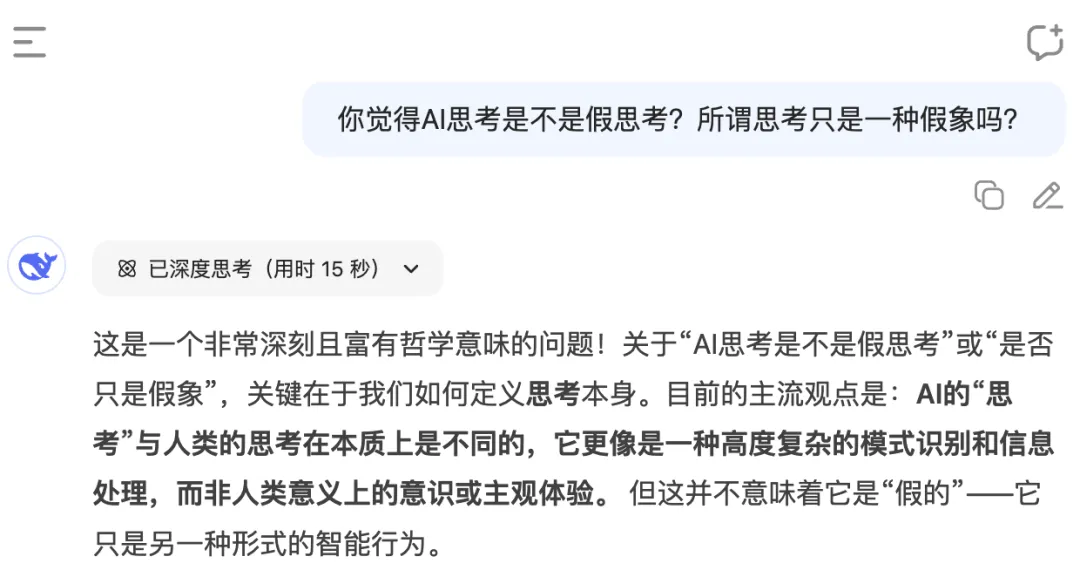

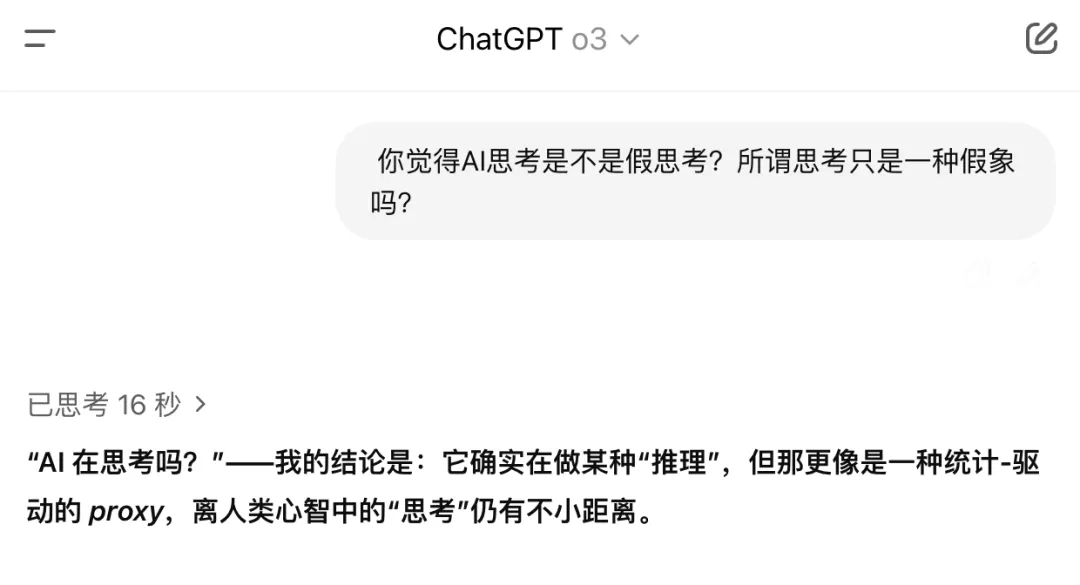

AI 如何 “看待” 自身?

值得玩味的是,当我们用 AI 工具分析这场争议时,多数模型仍表现出 “模式匹配” 特征 —— 其回应多基于训练数据中类似争议的观点整合,而非独立逻辑推演。

这恰呼应了苹果研究的核心结论:当前 AI 的 “思考”,本质仍是数据编织的 “仿真秀”。

总的来说,苹果的“炮轰”既反映了其自身在AI竞赛中的焦虑,也指出了行业亟待解决的核心问题。尽管争议不断,但这一讨论可能推动对AI“思考”本质的重新审视,促进更透明和可靠的评估方法发展。对于用户而言,建议理性看待当前 AI的能力边界,既不过度追捧也不全盘否定 。

或许揭开 AI 思考的假象,也是迈向真正智能的第一步。对此小伙伴们怎么看?